Tabla de Contenidos

- Resumen Ejecutivo y Hallazgos Clave

- Panorama del Mercado y Pronósticos de Crecimiento (2025–2030)

- Technologías Clave en el Modelado de Cinemática de Tejidos Blandos

- Integración con Plataformas Quirúrgicas Robóticas

- Empresas Líderes y Alianzas Estratégicas

- Aplicaciones Clínicas y Casos de Uso

- Desarrollos Regulatorios y Normativos

- Desafíos en la Precisión del Modelado y el Rendimiento en Tiempo Real

- Tendencias Emergentes: IA, Simulación y Enfoques de Gemelos Digitales

- Perspectivas: Direcciones Futuras y Oportunidades (2025–2030)

- Fuentes y Referencias

Resumen Ejecutivo y Hallazgos Clave

El modelado de cinemática de tejidos blandos se ha convertido en un habilitador crítico en la evolución continua de la cirugía robótica, siendo 2025 un punto de inflexión para su adopción y madurez tecnológica. A medida que los procedimientos asistidos por robots se expanden en cirugía general, urológica, ginecológica y cardiotorácica, la necesidad de un modelado preciso y en tiempo real de la deformación de tejidos blandos es primordial para la precisión, la seguridad y la mejora de los resultados en los pacientes.

Durante el último año, los líderes de la industria han acelerado la integración de modelos computacionales avanzados y inteligencia artificial (IA) en sus plataformas robóticas. www.intuitive.com introdujo mejoras en su sistema da Vinci, aprovechando el modelado cinemático para mejorar la retroalimentación de la interacción herramienta-tejido y el control de movimiento adaptativo. De manera similar, www.medtronic.com ha incorporado algoritmos de seguimiento de tejidos blandos en su sistema de cirugía robótica asistida Hugo™, apoyando manipulaciones más matizadas en anatomías variables.

Las colaboraciones de investigación con centros académicos han arrojado resultados prometedores en el modelado basado en datos, utilizando imágenes intraoperatorias y fusión de sensores. Por ejemplo, el www.surgicalroboticslab.nl ha demostrado modelos híbridos basados en física y aprendizaje automático que pueden predecir el movimiento de tejidos blandos en tiempo real, impactando directamente la planificación quirúrgica y la precisión de la navegación.

Los hallazgos clave para 2025 incluyen:

- Mejoras rápidas en la velocidad y fidelidad del modelado de tejidos blandos, con latencia que cae por debajo de los 100 milisegundos en las plataformas líderes, permitiendo actualizaciones casi instantáneas durante la cirugía.

- Mayor adopción del modelado impulsado por IA, evidenciado por colaboraciones como la de www.siemens-healthineers.com colaborando con fabricantes de dispositivos médicos para integrar la predicción de deformaciones de tejidos impulsada por IA en flujos de trabajo de imágenes.

- Emergencia de marcos de modelado de código abierto e interoperables, como los promovidos por la comunidad www.ros.org, que fomentan la estandarización y aceleran la innovación en el sector.

- Aumento del compromiso regulatorio; la www.fda.gov está desarrollando activamente pautas para tecnologías de IA y modelado en robótica quirúrgica, facilitando un camino más claro para la adopción clínica.

Mirando hacia el futuro, el consenso de la industria sugiere que para 2027, el modelado de tejidos blandos en tiempo real y específico para el paciente será una característica estándar en los sistemas de cirugía robótica de nueva generación. Se espera que este progreso reduzca aún más las tasas de complicaciones, acorte las curvas de aprendizaje para los cirujanos y expanda la gama de procedimientos aptos para asistencia robótica, mejorando en última instancia la atención quirúrgica global.

Panorama del Mercado y Pronósticos de Crecimiento (2025–2030)

El panorama del mercado para el modelado de cinemática de tejidos blandos en cirugía robótica está evolucionando rápidamente, impulsado por avances en modelado computacional, integración de sensores e inteligencia artificial. A partir de 2025, la adopción de soluciones de modelado de tejidos blandos se está acelerando en paralelo con el mercado más amplio de la cirugía robótica, que continúa expandiéndose tanto en volumen como en sofisticación. Este crecimiento está impulsado por la demanda de mayor precisión quirúrgica, trauma reducido para el paciente y mejores resultados postoperatorios, beneficios directamente vinculados al modelado en tiempo real y específico para el paciente del comportamiento de los tejidos blandos.

Los jugadores clave en la industria como www.intuitive.com, corporate.olympus-global.com y www.medtronic.com están expandiendo sus esfuerzos de I&D para integrar cinemática de tejidos blandos avanzados en sus plataformas. Por ejemplo, los sistemas da Vinci de Intuitive Surgical están incorporando cada vez más capacidades mejoradas de imágenes y retroalimentación de fuerza diseñadas para facilitar el modelado en tiempo real de deformaciones de tejido. De manera similar, el sistema de cirugía robótica asistida Hugo™ de Medtronic se está posicionando para aprovechar el modelado basado en datos para un control más intuitivo del cirujano y una mejor toma de decisiones intraoperatoria. Mientras tanto, Olympus está invirtiendo en plataformas de imagen médica y endoscópicas que pueden ser sinergizadas con módulos de simulación de tejidos blandos, con el objetivo de proporcionar información predictiva durante procedimientos mínimamente invasivos.

Las colaboraciones académicas e industriales están catalizando la innovación en este ámbito. Iniciativas como la www.surgicalroboticslab.nl están trabajando junto a socios comerciales para perfeccionar modelos biomecánicos que pueden ser implementados en sistemas robóticos clínicos. Se espera que estas colaboraciones maduren en soluciones comercialmente disponibles en los próximos años, alineándose con las tendencias de la industria hacia una mayor automatización y digitalización en el quirófano.

Desde una perspectiva de crecimiento, se prevé que la integración del modelado de cinemática de tejidos blandos pase de proyectos piloto y prototipos de investigación hacia una adopción clínica más amplia para 2030. A medida que los robots quirúrgicos se vuelven más comunes en hospitales de todo el mundo, los caminos de aprobación regulatoria también se están simplificando; la Administración de Alimentos y Medicamentos de EE. UU. (www.fda.gov) está colaborando activamente con las partes interesadas para establecer estándares para la seguridad y eficacia del modelado impulsado por IA en cirugía robótica. Se espera que esta claridad regulatoria acelere la inversión y la comercialización.

En resumen, entre 2025 y 2030, se espera que el modelado de cinemática de tejidos blandos pase de ser una característica diferenciadora a un requisito central para los sistemas de cirugía robótica de próxima generación. Este cambio desbloqueará nuevas oportunidades de mercado para los proveedores de tecnología y mejorará dramáticamente los resultados quirúrgicos en todo el mundo, marcando una nueva era de precisión y personalización en la atención operativa.

Tecnologías Clave en el Modelado de Cinemática de Tejidos Blandos

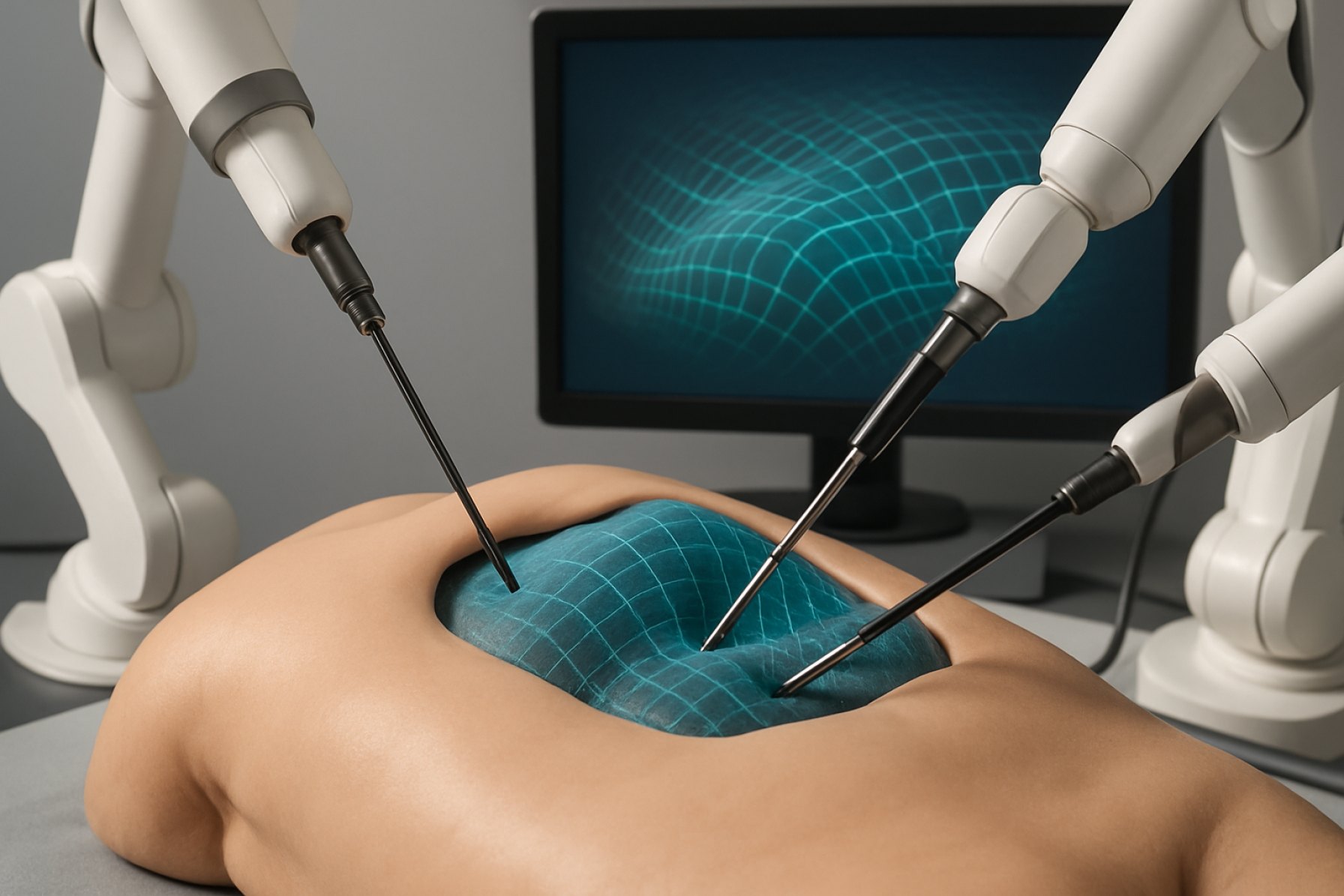

El modelado de cinemática de tejidos blandos se erige como una piedra angular en el avance de la cirugía robótica, permitiendo una manipulación precisa, planificación e interacción en tiempo real con tejidos biológicos deformables. A partir de 2025, el campo se caracteriza por una rápida integración de modelado computacional, tecnologías de sensores e inteligencia artificial (IA) para abordar los desafíos inherentes que plantea el comportamiento complejo, no lineal y específico del paciente de los tejidos blandos durante los procedimientos quirúrgicos.

Una tecnología fundamental es el modelado por elementos finitos (FEM), que permite simulaciones de alta fidelidad de la deformación del tejido bajo diversas fuerzas. Empresas como www.intuitive.com, fabricantes del sistema quirúrgico da Vinci, han desarrollado algoritmos propietarios para asistir con la guía intraoperatoria, aprovechando datos de imágenes preoperatorias para crear modelos específicos del paciente para mejorar la planificación quirúrgica. Los avances recientes se centran en el cálculo FEM en tiempo real, permitiendo ajustes adaptativos a medida que los tejidos son manipulados durante la cirugía.

Complementando el FEM, las tecnologías de seguimiento de tejidos en tiempo real utilizan modalidades de imagen avanzadas como ultrasonido intraoperatorio y tomografía de coherencia óptica (OCT). Por ejemplo, www.sss.us integra imágenes de alta resolución con sus sistemas robóticos para actualizar dinámicamente los modelos de deformación de tejidos blandos, proporcionando a los cirujanos visualizaciones precisas y actuales del campo operatorio.

El aprendizaje automático (ML) y la IA están cada vez más integrados en las plataformas de modelado, habilitando cinemáticas predictivas y movimientos compensatorios del robot. www.cmrsurgical.com está desarrollando activamente algoritmos impulsados por IA para su plataforma Versius que predicen el comportamiento del tejido en función de datos de sensores en vivo, con el objetivo de minimizar el trauma y optimizar la colocación de suturas. Estos modelos de IA se entrenan en grandes conjuntos de datos de videos quirúrgicos y datos de sensores de fuerza y son validados a través de estudios clínicos en curso.

Los sistemas de retroalimentación háptica forman otro componente clave, traduciendo datos cinemáticos complejos en señales táctiles para el cirujano. Empresas como www.medtronic.com han introducido interfaces hápticas avanzadas en su sistema Hugo™ RAS, permitiendo retroalimentación de fuerza en tiempo real que refleja la resistencia del tejido modelado, mejorando así la destreza quirúrgica y reduciendo el riesgo de daños inadvertidos.

Las perspectivas para los próximos años apuntan hacia una mayor convergencia de estas tecnologías, con un fuerte énfasis en la personalización, la automatización y el control de circuito cerrado. Se espera que las colaboraciones en curso entre fabricantes de dispositivos, laboratorios de investigación académica y proveedores de tecnología de imágenes generen soluciones robustas y aprobadas por reguladores para el modelado de tejidos blandos. Además, se anticipa que la integración de la computación basada en la nube y el aprendizaje federado acelere el perfeccionamiento y la transferibilidad de los modelos a través de diversas poblaciones de pacientes y procedimientos quirúrgicos.

Integración con Plataformas Quirúrgicas Robóticas

La integración del modelado de cinemática de tejidos blandos en plataformas quirúrgicas robóticas está acelerándose significativamente en 2025, impulsada tanto por avances tecnológicos como por la creciente demanda clínica de mayor precisión quirúrgica. Los sistemas robóticos modernos dependen cada vez más del modelado en tiempo real de la deformación de tejidos para mejorar la retroalimentación al cirujano, la guía de instrumentos y la toma de decisiones intraoperatorias. Los actores clave en el campo, como www.intuitive.com y www.medtronic.com, están incorporando activamente o pilotando módulos de modelado cinemático dentro de sus plataformas insignia.

Un aspecto central de esta integración es el uso de imágenes avanzadas (por ejemplo, ultrasonido intraoperatorio, endoscopía en tiempo real) y fusión de sensores para parametrizar la dinámica de los tejidos blandos. Por ejemplo, www.intuitive.com está evaluando algoritmos de aprendizaje automático que se adaptan a las características específicas del tejido del paciente, lo que permite una manipulación más responsive y reduce el riesgo de lesiones no intencionadas. De manera similar, www.medtronic.com está diseñado con compatibilidad para mejoras de software de terceros, allanando el camino para la integración de modelado cinemático en tiempo real como una actualización de software.

Las colaboraciones académicas también están impulsando la innovación en este espacio. A principios de 2025, www.siemens-healthineers.com anunció asociaciones con varios hospitales universitarios para probar algoritmos de seguimiento de tejidos blandos basados en IA, con el objetivo de integrarlos directamente en los sistemas de navegación quirúrgica. Estos esfuerzos se están combinando con ensayos clínicos del mundo real para validar la seguridad y el rendimiento, especialmente en procedimientos complejos que involucran órganos altamente móviles como el hígado o los pulmones.

La interoperabilidad sigue siendo un desafío y una oportunidad focal. Grupos de la industria como la www.aami.org están redactando actualmente estándares de interoperabilidad que permitirán que los datos de modelado cinemático se intercambien sin problemas entre diferentes plataformas robóticas, dispositivos de imagen y sistemas de registros hospitalarios. Se espera que esto acelere la adopción del modelado cinemático, creando un ecosistema más unificado para la cirugía mínimamente invasiva basada en datos.

Mirando hacia los próximos años, se espera una integración más profunda del modelado de cinemática de tejidos blandos como un componente esencial de las plataformas de cirugía robótica. Con los organismos reguladores mostrando un apoyo creciente para la guía quirúrgica digitalmente mejorada, y con los principales proveedores ahora integrando estas capacidades de manera nativa, es probable que para finales de la década, el modelado de tejidos blandos en tiempo real sea una característica estándar en los sistemas de cirugía robótica líderes.

Empresas Líderes y Alianzas Estratégicas

El panorama del modelado de cinemática de tejidos blandos para cirugía robótica está siendo moldeado por colaboraciones entre los principales fabricantes de cirugía robótica, empresas de tecnología de imagen avanzadas y centros médicos orientados a la investigación. A medida que crece la demanda de mayor precisión y adaptabilidad en procedimientos mínimamente invasivos, los líderes de la industria están forjando alianzas estratégicas para integrar un modelado mejorado en sus plataformas quirúrgicas.

Uno de los jugadores más destacados en este dominio es www.intuitive.com, conocido por su Sistema Quirúrgico da Vinci. En los últimos años, Intuitive ha acelerado sus esfuerzos por mejorar el modelado de tejidos blandos al establecer asociaciones con empresas de tecnología de imágenes y centros de investigación académica. En 2024, Intuitive anunció una colaboración con www.siemens-healthineers.com para desarrollar conjuntamente soluciones de imágenes intraoperatorias en tiempo real que mejoren la precisión del seguimiento de tejidos blandos durante procedimientos asistidos por robots. Esta asociación tiene como objetivo fusionar las plataformas avanzadas de imágenes de Siemens con los sistemas robóticos de Intuitive para un modelado más dinámico y sensible de la deformación de los tejidos.

Otra empresa notable, www.medtronic.com, continúa invirtiendo en su sistema de cirugía asistida por robots Hugo™ integrando algoritmos de modelado de tejidos blandos impulsados por IA. En 2025, Medtronic amplió su asociación estratégica con www.philips.com para aprovechar las capacidades de imágenes y navegación en tiempo real de Philips, con el objetivo de ofrecer cinemáticas predictivas y visualización aumentada del comportamiento del tejido durante procedimientos complejos. Se espera que esta integración mejore la retroalimentación del sistema y la confianza del cirujano, particularmente en entornos de tejidos variables.

Las startups y empresas impulsadas por la investigación también están haciendo contribuciones significativas. www.robocath.com, una empresa francesa especializada en robótica vascular, ha iniciado asociaciones con hospitales universitarios europeos para perfeccionar modelos de interacción de tejidos blandos para aplicaciones endovasculares. Mientras tanto, www.cmr-surgical.com, con su sistema Versius, ha colaborado con instituciones de investigación del Reino Unido para co-desarrollar modelos de aprendizaje automático que predicen la respuesta de los tejidos blandos, con el objetivo de lograr una manipulación robótica más segura y adaptada.

Mirando hacia el futuro, se espera que estas alianzas estratégicas aceleren la traducción del modelado avanzado de cinemática de tejidos blandos desde laboratorios de investigación hasta quirófanos. La colaboración entre fabricantes de sistemas robóticos, líderes en tecnología de imágenes y socios académicos probablemente definirá la próxima generación de robótica quirúrgica, permitiendo intervenciones más inteligentes, contextualizadas y específicas para el paciente en los próximos años.

Aplicaciones Clínicas y Casos de Uso

El modelado de cinemática de tejidos blandos está avanzando rápidamente las aplicaciones clínicas de la cirugía robótica al permitir intervenciones precisas, adaptativas y mínimamente invasivas. A partir de 2025, la integración de modelos de deformación de tejidos blandos en tiempo real se ha vuelto cada vez más factible con las mejoras en la potencia computacional, la fusión de sensores y la inteligencia artificial. Estos desarrollos están impactando directamente especialidades quirúrgicas como urología, ginecología, cirugía general y procedimientos cardiotorácicos.

Una de las plataformas más prominentes, el Sistema Quirúrgico da Vinci, desarrollado por www.intuitive.com, está incorporando algoritmos basados en aprendizaje automático para el seguimiento de tejidos y el modelado predictivo. Estas características permiten que el sistema compense el movimiento y la deformación de los tejidos durante procedimientos como prostatectomía y nefrectomía parcial, conduciendo a una mayor precisión en los márgenes y a la reducción de complicaciones.

Otro esfuerzo pionero proviene de www.medtronic.com con su sistema de Cirugía Asistida Robótica Hugo™. El sistema Hugo aprovecha datos en tiempo real de imágenes endoscópicas y sensores de retroalimentación háptica para modelar dinámicamente el comportamiento de los tejidos blandos. Esta capacidad se está pilotando en entornos clínicos para mejorar la precisión en cirugías colorectales y ginecológicas, con resultados preliminares que indican reducciones en el tiempo de operación y los períodos de recuperación postoperatoria.

Paralelamente, la plataforma www.cmrsurgical.com está demostrando la integración del modelado de cinemática de tejidos blandos para optimizar la colocación de puertos y la trayectoria de instrumentos, particularmente en procedimientos complejos que abarcan múltiples cuadrantes. El diseño modular del sistema permite actualizaciones iterativas a sus algoritmos de modelado, y los casos de uso clínico recientes han mostrado beneficios en la reducción de lesiones iatrogénicas y en la mejora de la eficiencia del flujo de trabajo.

Los centros médicos académicos y los hospitales de investigación también están colaborando con socios de la industria para validar estas tecnologías en ensayos clínicos del mundo real. Por ejemplo, www.mayo.edu está trabajando en tuberías de modelado de tejidos impulsadas por IA para guiar la sutura y resección robótica en cirugías hepatobiliares, con el objetivo de minimizar aún más el error humano y estandarizar los resultados.

Mirando hacia el futuro, se espera que el modelado de cinemática de tejidos blandos facilite la próxima generación de intervenciones robóticas autónomas y semi-autónomas. Estos avances pueden extenderse a procedimientos complejos, como la reparación de válvulas cardíacas y el trasplante de órganos, donde la interacción dinámica del tejido es crítica. A medida que los marcos regulatorios y los estándares de interoperabilidad de datos maduran, se prevé que la adopción clínica de estas tecnologías se acelere, con estudios multi-institucionales y vigilancia post-comercialización moldeando su impacto a largo plazo en la seguridad del paciente y la eficacia quirúrgica.

Desarrollos Regulatorios y Normativos

El panorama regulatorio para el modelado de cinemática de tejidos blandos en cirugía robótica está evolucionando rápidamente a medida que la integración de simulaciones avanzadas y tecnologías impulsadas por IA se convierte en central para procedimientos mínimamente invasivos. Las agencias regulatorias están reconociendo cada vez más la necesidad de marcos claros para evaluar la seguridad, eficacia e interoperabilidad de estas soluciones de modelado, que son críticas para la navegación quirúrgica en tiempo real y para mejorar los resultados en los pacientes.

En 2024 y hasta 2025, la www.fda.gov ha avanzado en su enfoque para la supervisión de software de inteligencia artificial (IA) y aprendizaje automático (ML) como dispositivos médicos (SaMD), incluidos aquellos que sustentan el modelado de cinemática de tejidos blandos. La agencia está pilotando un “Plan de Control de Cambios Predeterminados” que permite que los modelos basados en IA, como aquellos que predicen o simulan la deformación de tejidos blandos durante la cirugía robótica, sean actualizados post-aprobación bajo condiciones preespecificadas, apoyando la innovación continua mientras mantiene la seguridad del paciente.

Mientras tanto, el ec.europa.eu continúa estableciendo requisitos estrictos para la evaluación clínica y la vigilancia post-comercialización de dispositivos médicos, incluidas las plataformas de cirugía robótica que emplean modelado en tiempo real de tejidos. La UE está además armonizando estándares de evaluación de salud digital, con organizaciones como www.medtecheurope.org trabajando con partes interesadas para aclarar las expectativas para componentes de IA y simulación utilizados en robots quirúrgicos.

- En 2024, www.intuitive.com anunció mejoras en su plataforma da Vinci y en su sistema endoluminal Ion, incorporando herramientas de modelado y simulación impulsadas por IA para la manipulación de tejidos blandos. Las aprobaciones regulatorias para estas características están guiadas por los marcos en evolución de la FDA y la UE en torno a actualizaciones de software, transparencia y validación de modelos cinemáticos.

- www.cmrsurgical.com y otros líderes de la industria están participando activamente con organismos reguladores para establecer mejores prácticas para la validación y prueba clínica de algoritmos de simulación de tejidos blandos, reconociendo que la generación de evidencia robusta es esencial para futuras aprobaciones.

- Consorcios de la industria como www.aami.org están desarrollando nuevos estándares técnicos específicos para la calidad del software, la precisión del modelado en tiempo real y los factores humanos en cirugía robótica, con el objetivo de lograr una alineación internacional.

Mirando hacia el futuro, en los próximos años se espera que los reguladores publiquen orientaciones más detalladas específicas para el modelado cinemático impulsado por IA, incluidos requisitos para la procedencia de datos, algoritmos de aprendizaje continuo e interoperabilidad con sistemas quirúrgicos existentes. Se espera que estos desarrollos aceleren la adopción segura de tecnologías de modelado de tejidos blandos de próxima generación, fomentando una mayor confianza entre los clínicos y los pacientes por igual.

Desafíos en la Precisión del Modelado y el Rendimiento en Tiempo Real

El modelado de cinemática de tejidos blandos para cirugía robótica enfrenta desafíos persistentes y complejos para lograr tanto alta precisión como rendimiento en tiempo real, especialmente a medida que el campo avanza en 2025 y más allá. Las propiedades inherentes de los tejidos blandos—no linealidad, viscoelasticidad, anisotropía y heterogeneidad—hacen que el modelado preciso sea fundamentalmente difícil. Además, estas propiedades pueden variar significativamente entre pacientes e incluso dentro de diferentes regiones del mismo órgano durante la cirugía, complicando el desarrollo de modelos robustos y generalizables.

Un desafío central radica en las demandas computacionales de simular la deformación de tejidos blandos en tiempo real. Los métodos tradicionales de elementos finitos (FEM) y los modelos basados en física ofrecen alta precisión, pero a menudo son demasiado intensivos computacionalmente para la aplicación intraoperatoria sin una simplificación sustancial, lo que introduce compromisos en precisión. Si bien empresas como www.intuitive.com y www.cmrsurgical.com están desarrollando activamente plataformas robóticas avanzadas, dependen de modelos simplificados o basados en datos para abordar estas limitaciones en tiempo real.

Los años recientes han visto una mayor integración de técnicas de aprendizaje automático para aproximar la mecánica del tejido y predecir la deformación, proporcionando tiempos de inferencia más rápidos. Sin embargo, estos modelos dependen en gran medida de la cantidad y diversidad de los datos de entrenamiento, que siguen siendo limitados debido a preocupaciones de privacidad, la dificultad logística de obtener datos intraoperatorios y la variabilidad en las propiedades del tejido. Los esfuerzos de organizaciones como www.surgicalroboticschallenge.org han provocado iniciativas de comparación colaborativa, pero los conjuntos de datos estandarizados siguen siendo escasos en 2025.

La integración de sensores presenta otro cuello de botella. La retroalimentación en tiempo real de sensores de fuerza, cámaras estereoscópicas e imágenes intraoperatorias (por ejemplo, ultrasonido) es vital para la actualización dinámica de modelos. Sin embargo, a partir de 2025, la precisión, latencia y miniaturización de estos sensores—ofrecidos por proveedores como www.ati-ia.com—sigue madurando para cumplir con los estrictos requisitos de los sistemas robóticos clínicos. Además, el movimiento de tejidos blandos debido a procesos fisiológicos como la respiración y el latido del corazón agrega más imprevisibilidad, lo que requiere algoritmos adaptativos capaces de aprendizaje y ajuste continuo durante la cirugía.

Mirando hacia el futuro, se espera que los próximos años traigan mejoras incrementales. Se anticipa que los avances en computación GPU, IA en el borde y tecnología de sensores mejoren el rendimiento en tiempo real de los modelos cinemáticos. Los marcos colaborativos e iniciativas de código abierto probablemente facilitarán la creación de conjuntos de datos más ricos para el entrenamiento y validación de modelos. Sin embargo, lograr un modelado robusto, en tiempo real y específico para el paciente de la cinemática de tejidos blandos sigue siendo un desafío formidable que continuará impulsando la investigación y la innovación en plataformas de cirugía robótica.

Tendencias Emergentes: IA, Simulación y Enfoques de Gemelos Digitales

El panorama del modelado de cinemática de tejidos blandos para cirugía robótica está experimentando una rápida transformación, impulsada por avances en inteligencia artificial (IA), simulación de alta fidelidad y tecnologías de gemelos digitales. A partir de 2025, estas innovaciones están abordando los desafíos de larga data en la predicción y replicación precisa del comportamiento complejo y no lineal de los tejidos blandos durante procedimientos mínimamente invasivos.

El modelado impulsado por IA está en la vanguardia, permitiendo a los sistemas robóticos procesar vastos conjuntos de datos intraoperatorios para una adaptación en tiempo real. Empresas como www.intuitive.com están integrando algoritmos de aprendizaje automático en sus plataformas para mejorar la clasificación de tejidos, la retroalimentación de fuerza y la planificación de movimientos. Estos modelos se entrenan en grandes repositorios de datos quirúrgicos, lo que permite que los robots anticipen mejor la deformación de los tejidos y ajusten las trayectorias de las herramientas dinámicamente. Esto resulta en una mejor precisión y seguridad, especialmente en entornos delicados como la neurocirugía y las intervenciones cardíacas.

Las plataformas de simulación se están volviendo cada vez más sofisticadas, con modelos basados en física y datos ahora capaces de replicar las propiedades viscoelásticas de los órganos en entornos virtuales. www.siemens-healthineers.com y www.medtronic.com están aprovechando estos modelos para la planificación y ensayo preoperatorio, permitiendo a los cirujanos practicar en réplicas digitales específicas del paciente. Estas simulaciones no solo mejoran los resultados quirúrgicos, sino que también sirven como valiosas herramientas de entrenamiento, acelerando la curva de aprendizaje para nuevos procedimientos y tecnologías.

Una tendencia emergente significativa es el despliegue de la tecnología de gemelos digitales—una representación virtual en tiempo real de la anatomía del paciente y el comportamiento del tejido, actualizada continuamente con datos intraoperatorios. www.philips.com presentó recientemente un gemelo digital impulsado por IA para el cuidado cardíaco, que ejemplifica el potencial del modelado dinámico de tejidos blandos durante la cirugía. Estos gemelos digitales permiten análisis predictivos, proporcionando a los cirujanos información útil, como estimar el desplazamiento o la tensión de los tejidos según las manipulaciones robóticas.

Mirando hacia adelante, los esfuerzos convergen en la integración de datos multimodales—combinando imágenes intraoperatorias, retroalimentación háptica y propiedades biomecánicas específicas del paciente para refinar aún más los modelos de cinemática de tejidos blandos. Las colaboraciones de la industria entre empresas de robótica y centros médicos académicos están acelerando el desarrollo de plataformas de código abierto y estándares interoperatorios, fomentando una adopción más amplia. A medida que los marcos regulatorios evolucionan para acomodar estos avances, se espera que los próximos años vean una mayor traducción clínica, con sistemas robóticos impulsados por IA y soportados por simulación estableciendo nuevos estándares para la precisión quirúrgica y la seguridad del paciente.

Perspectivas: Direcciones Futuras y Oportunidades (2025–2030)

Las perspectivas para el modelado de cinemática de tejidos blandos en cirugía robótica entre 2025 y 2030 están preparadas para un avance significativo, sustentadas por desarrollos rápidos en modelado computacional, tecnología de sensores e integración de inteligencia artificial. A medida que los robots quirúrgicos se vuelven más prevalentes en los quirófanos de todo el mundo, la demanda de un modelado preciso y en tiempo real de las interacciones de tejidos blandos se intensificará, apoyando la tendencia hacia procedimientos mínimamente invasivos y mejores resultados para los pacientes.

Una de las direcciones más prometedoras es la integración de modalidades de imagen en tiempo real—como ultrasonido intraoperatorio y endoscopía avanzada—directamente en el flujo de trabajo quirúrgico. Empresas como www.intuitive.com y www.medtronic.com ya están equipando sus plataformas robóticas con capacidades de imagen mejoradas. Durante los próximos cinco años, esto permitirá un seguimiento más preciso de la deformación de los tejidos y un control robótico más responsivo, especialmente cuando se combina con algoritmos de aprendizaje automático entrenados en grandes conjuntos de datos del comportamiento de los tejidos intraoperatorios.

Se espera que los enfoques impulsados por datos pasen de modelos estáticos o preoperatorios a simulaciones dinámicas, específicas para el paciente. Iniciativas como la www.surgicalroboticslab.nl están desarrollando marcos de modelado en tiempo real que se adaptan continuamente a los cambios en los tejidos durante la cirugía. Para 2030, se anticipa que tales modelos adaptativos se incorporarán rutinariamente en sistemas comerciales, facilitando una navegación más segura en tejidos delicados o altamente vascularizados.

La fusión de sensores—combinando retroalimentación de fuerza, táctil y visual—también madurará, lo que dará lugar a conjuntos de datos más ricos para el modelado cinemático. Por ejemplo, www.sensusrobotics.com está trabajando en sensores táctiles avanzados para procedimientos mínimamente invasivos. Cuando se integren con modelos cinemáticos, estas tecnologías permitirán que los robots no solo «vean», sino que también «sientan» y predigan el comportamiento de los tejidos blandos, mejorando la autonomía y reduciendo la carga cognitiva sobre los cirujanos.

Mirando hacia adelante, la convergencia de la computación en la nube y la robótica desbloqueará nuevas oportunidades en cirugía colaborativa y remota. Las plataformas en la nube seguras de proveedores como cloud.google.com se espera que permitan el intercambio y perfeccionamiento en tiempo real de modelos cinemáticos, acelerando el aprendizaje colectivo y estandarizando las mejores prácticas en diversas instituciones.

En resumen, se espera que los años 2025 a 2030 presencien la transición del modelado de cinemática de tejidos blandos de un enfoque de investigación a un elemento fundamental de la robótica quirúrgica, impulsando una mayor seguridad, automatización y atención personalizada para los pacientes en todo el mundo.

Fuentes y Referencias

- www.intuitive.com

- www.medtronic.com

- www.surgicalroboticslab.nl

- www.siemens-healthineers.com

- www.ros.org

- www.aami.org

- www.philips.com

- www.robocath.com

- ec.europa.eu

- www.ati-ia.com

- cloud.google.com